CTRL: Conditional Transformer Language Model 개념 정리

딥러닝 기반 자연어 생성 모델이 빠르게 발전하면서, “어떤 텍스트를 얼마나 잘 생성하느냐”뿐만 아니라 “어떻게 통제(Control)할 수 있느냐”가 중요한 화두로 떠올랐습니다. Salesforce Research에서 2019년 발표한 CTRL(Conditional Transformer Language Model)은 바로 이 문제를 해결하기 위해 고안된 모델입니다. CTRL은 ‘컨트롤 코드(Control Code)’라는 프리픽스를 도입해, 생성하고자 하는 도메인·스타일·태스크·메타정보 등을 명시적으로 지정할 수 있는 최초의 대규모 생성 언어 모델 중 하나입니다.

왜 ‘컨디셔널’ 언어 모델인가?

기존 언어 모델의 한계

전통적인 언어 모델은 다음 단어 예측 확률 (p(x_i \mid x_{<i}))만을 학습합니다.

- 블랙박스처럼 어떤 텍스트가 생성될지 제어하기 어려움

- 도메인·스타일 변화에 민감하게 대응 불가

CTRL의 목표

- 생성 텍스트의 특성 제어: 뉴스, 리뷰, Q&A, 코드 등 다양한 ‘컨트롤 코드’를 통해 텍스트 성격을 지정

- 완전 자동화된 학습: 복잡한 태그 지정 없이, 크롤링된 원천 데이터(URL·도메인 정보 포함)만으로 비지도학습

컨트롤 코드(Control Code)란 무엇인가?

컨트롤 코드 정의

- 텍스트 생성 시 앞에 붙이는 프리픽스(Prefix)

- 도메인(예: “[Wikipedia]”), 스타일(“[Review]”), 태스크(“[Translate]”), 날짜·출처(“[NYTimes/20200101]”) 등을 지정

자연스러운 통합 학습

- 위키피디아, Project Gutenberg, 아마존 리뷰, Reddit 서브레딧 등에서 도메인 이름을 코드로 사용

- URL 메타정보를 앞에 붙여, 모델이 도메인·날짜·객체 관계를 학습하도록 유도

- 별도 라벨링 없이, 원시(raw) 텍스트에 자연스럽게 부착된 메타정보 활용

모델 아키텍처

Transformer 기반 구성

- 토큰 임베딩(Token Embedding)

- 시퀀스 길이 (n)의 각 토큰을 (d)차원 벡터로 변환

- Sinusoidal 위치 임베딩 추가

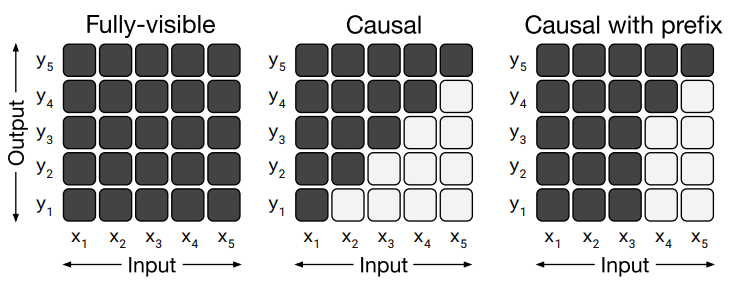

- Multi-Head Attention & Feed-Forward

- 총 48개 레이어, 각 레이어별 16개 헤드

- 미래 정보 차단(causal mask)으로 순차적 생성 보장

- FFN(Feed-Forward Network)은 중간 차원 (f=8192) → 출력 (d=1280)

- LayerNorm & Residual Connection

- 학습 안정화 및 그라디언트 흐름 개선

파라미터 규모

- 총 1.63B(16.3억) 파라미터

- 대규모 분산 학습 환경(TPU v3 Pod 256코어)에서 2주간 학습

학습 설정 및 최적화

데이터 전처리

- 140GB 방대한 텍스트: Wikipedia + OpenWebText

- BPE 토크나이징 (약 25만 개 토큰)

- 시퀀스 길이 256/512, sliding-window 기법 활용

하이퍼파라미터

- Batch size: 1024, Iteration: 800K 스텝

- Optimizer: Adagrad + linear warmup(0→0.05, 25K) + gradient clipping(0.25)

- Dropout: 0.1, Embedding 레이어 파라미터 공유

컨트롤 코드 우선순위

- 학습 데이터 분포 과도 반영 방지 위해 uniform prior 적용

- 도메인별 데이터 크기 편중 완화

텍스트 생성(추론) 기법

Temperature-controlled Sampling

- 점수 (s_i)를 온도 (T)로 조정:

[

p_i = \frac{\exp(s_i / T)}{\sum_j \exp(s_j / T)}

] - (T \to 0) → Greedy, (T \to \infty) → Uniform 랜덤

Top-k / Nucleus Sampling

- 누적 확률 (> p_t)인 최소 토큰 집합 선택

- 확률이 높은 소수 토큰만 후보로 하여 샘플링

Penalized Sampling

- 동어 반복 방지를 위해 이전에 생성된 토큰에 페널티 부여

- 실험적 설정: (\theta=1.2)일 때 반복 감소 효과 탁월

실험 결과 및 분석

도메인별 스타일 제어

- [AmazonReview] → 자연스러운 사용자 리뷰

- [Wiki] → 객관적이고 중립적인 백과사전 문체

태스크 지시 없이도 생성

- 컨트롤 코드만으로 Q&A, 요약, 번역 등 zero-shot 수행

- Google T5의 태스크 프리픽스와 유사한 효과 관찰

한계 및 문화적 편향

- 원시 데이터에 포함된 문화·편견 그대로 학습

- 모순된 진술 생성 사례 다수 관찰, 절대적 진실 보장 불가

적용 사례 및 활용 전망

맞춤형 챗봇

- 성별·연령 따른 언어 스타일 제어

- 페르소나(Persona) 부여된 대화 시스템

자동 리뷰 생성

- 상품·서비스 리뷰, 평점, 요약문 출력

문체 변환 및 편집 보조

- 공식문체→구어체, 요약문→전문가 리뷰 등 스타일 변환

결론 및 시사점

CTRL은 ‘프롬프트(prompt) + 컨트롤 코드’ 구조만으로도 대규모 언어 모델의 출력을 세밀하게 제어할 수 있음을 보여준 획기적 연구입니다.

- 컨트롤 코드라는 아이디어는 이후 T5, GPT 계열의 프롬프트 설계 발전에 큰 영감을 주었고,

- 자연어 생성 기능의 응용 범위를 획기적으로 확장했습니다.

다만, 대규모 파라미터와 방대한 학습 자원, 내재적 편향 문제는 여전히 해결 과제로 남아 있습니다. 사용자는 생성된 텍스트의 품질과 윤리적 측면을 함께 고려해야 하며, 컨트롤 코드 설계 시에도 데이터 출처와 문화적 배경을 충분히 검토해야 할 것입니다.

향후 연구에서는

- 더욱 효율적인 파라미터 절감 기법,

- 공정성(fairness)을 고려한 컨트롤 코드 설계,

- 실시간 적응형 프롬프트 최적화 등이 활발히 논의될 것으로 보입니다.

CTRL 논문에서 제안된 ‘도메인 메타정보를 자연스럽게 통합하여 비지도학습으로 컨디셔닝 학습’ 방식은, 어떠한 사용자 맞춤형 언어 생성 서비스에도 응용할 수 있는 핵심 아이디어입니다. 여전히 진화하는 이 분야에서, CTRL의 개념을 잘 이해하고 응용한다면 보다 정교하고 유연한 자연어 생성 애플리케이션을 개발할 수 있을 것입니다.